安徽互聯網聯盟(ahunion.org)主辦的站長講座不知不覺到了第十二期。上期的講座獲得了眾多參與站長很高的贊譽也讓更多的站長積極的加入到講座群內來,目前在國內最知名的網站采集軟件肯定就似乎火車頭采集器(locoy.com)了,火車采集器(LocoySpider)是一個功能強大的數據采集軟件.使用它關鍵詞搜索引擎標題采集軟件,您可以很容易的從網頁上抓取文字,圖片,文件等資源.目前是國內使用率最高的網站采集軟件,前不久剛推出了2009的最新版,深受廣大站長的喜愛。由于該采集器的創始人李進斌正好是安徽老鄉,前不久去年底的安徽站長聚會上有過合作,所以李兄很爽快的就答應了老K我來和站長朋友們聊聊,由于李兄是技術出生打字速度不快,所以在算算的一個半小時內說的內容不太多,但是非常精辟,大家看了便明白了,希望能給諸位站長帶來幫助。由于講座主群已滿 新到站長可加直播群:47744157進行專題講座 我們隨時會T從來不發言的站長 讓更多想學習的站長進來。

一、談火車頭采集器的由來

火車頭:我們的這個采集器最早是從05年底開始有這個想法的,當時也是和大家一樣,個人站長,添加管理維護網站很辛苦,一篇篇修改復制發布最開始也是接觸dede 然后發現他有個外部的c#采集器。不知道有多少人也記得,我的思路基本是從這個dedespider學來的,原來真的不懂什么,到后來學會php和.net,所以只要大家有興趣,技術上的問題都可以克服,講到現在的采集,其實采集只能替代站長部分手工的操作。我們不建議大規模得制造垃圾站(全盤得采集復制別人的站點),所以我們現在的軟件的功能越做越多,但新用戶缺越來越不會用了。

我們現在有一批很忠實的會員,他們一直在靠采集器更新網站。迅速的采集然后百度搜錄帶來巨大的流量的時代已經不在,站長還是要關注內容,靠采集器采集的數據一樣要注意,前期只能做為一個數據填充,可以稍微大的。但時間長了,目標就要把垃圾數據也要變成精品,否則做不長久

二、關于采集網站的經驗

火車頭:我們現在在更新這個采集器,在數據采集方面也積累了一些經驗,增加更多功能以適應新形式下的采集

1.別人經常采的網站不要去采

2.太容易采的網站不要去采

3.不要一次性采集太多,一定要注意后期處理(后面詳續)

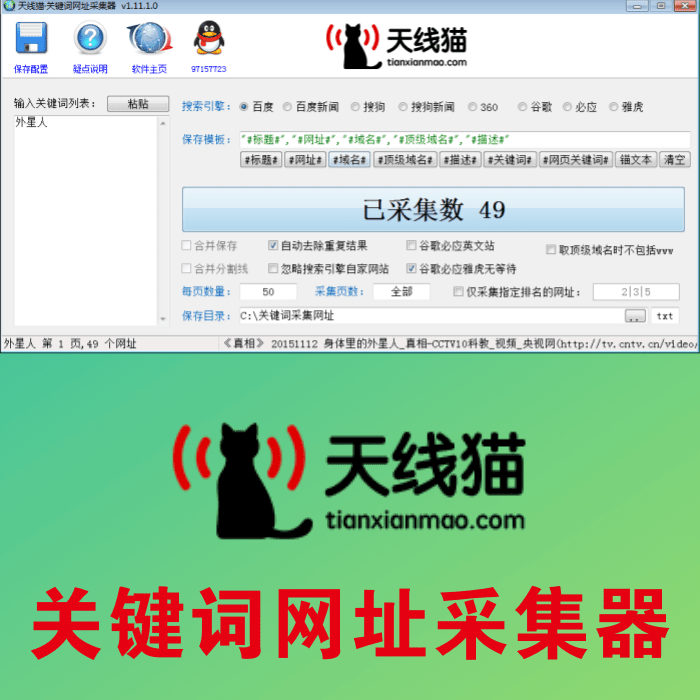

4.做好關鍵詞,tag的采集分析

5.自己網站要有自己的定位,不采與自己網站無關的內容

6.采集也要有持續性,經常更新,自動采集功能我們也有,但還是建議大家人工也參與一些審核,或定時,亂序發布

后期處理,要想法子做到讓搜索引擎那看不出來兩片文章的相同,這里面應該有很多SEO高手,那我不獻丑了。我說下我們現在實現的功能,大家可以把這些混用,達到改變內容偽原創:

1.給標題。內容分詞

2.使用同義詞近義詞替換,排除敏感詞,不同的標簽之間數據融合,指如標題內容之間數據的相互替換

3.給文章加上摘要

4.為文章標題等生成拼音地址

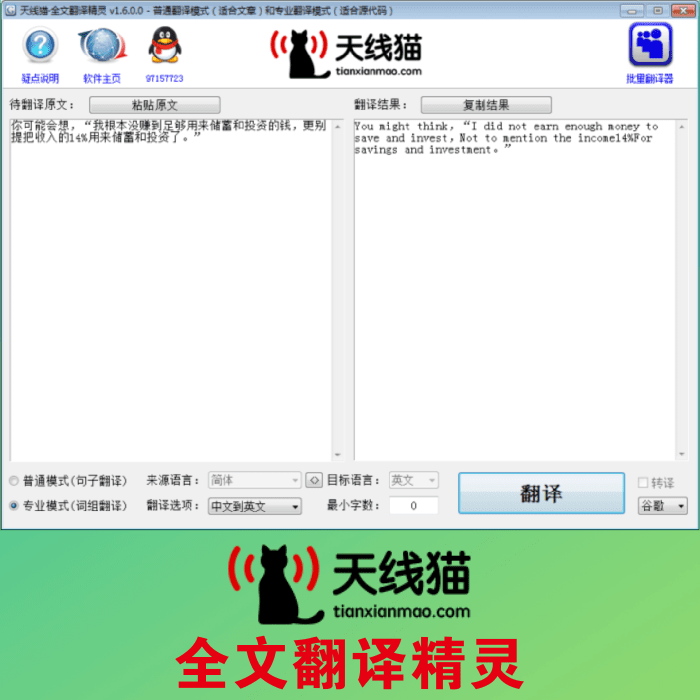

5.采集一些其他編碼的網站,我們可以做到簡繁體轉化,可以采集中文網站翻譯成英文(雖然比較垃圾,但應該可以算是原創)

我們也發現,高難度采集的網站一般內容質量都非常好,采集其實有時也是一件很有樂趣的事情,需要你學習一些采集相關的知識。

描述采集三、關于防采集的方法

火車頭:下面講一些主要的防采集方法。可以說是攻防對戰吧。打開一個網頁實際就是一個Http請求瀏覽器。百度蜘蛛,小到我們的采集器使用的都是一個原理,模擬http請求,所以我們同樣能模擬出瀏覽器。百度蜘蛛出來所以絕對的防采集根本不存在,只是難度的高低。或者你認為搜索引擎的搜錄也無所謂了。你可以用一些非常強大的activex,flash,全圖片文字的形式,這個我們無能為力。

普通的防采集方法有

1、來源判斷

2、登錄信息判斷 Cookie

3、請求次數判斷。如一段時間內請求多少關鍵詞搜索引擎標題采集軟件,非常規操作則封IP

4、發送方式判斷 POST GET 使用JS,Ajax等請求內容

舉例:

1.2不用說了,論壇,下載站等關鍵詞搜索引擎標題采集軟件。。

3、一些大網站,需要配置服務器,單純靠腳本判斷資源消耗比較大

4、如一些招聘站,asp.net的分頁,Web2.0站的ajax請求內容

當然我們后面還發現一些殺手锏,今天第一次在這里給大家公布出來~~ 有優質內容需要防采集的朋友可以考慮試下

1、網頁默認deflate壓縮輸出(gzip容易一點,容易解壓) 我們普通的瀏覽器和baidu支持識別gzip,deflate輸出內容

2、網頁內容不定時 \0 內容自動截斷,這兩點基本可以防主大部分主流軟件采集及web采集程序了~

今天主要想要表達的一點,大家在做站時一定要注意技術的提高,比如我們里面有后期外部php及.net接口處理采集數據。或者干脆你自己做一個發布時的接口程序自己入庫。我們偽原創做得再好,一樣有非常多的會員使用,那樣又不原創了,采集一樣需要技術,只有你通過采集器獲得了沒有多少人有的數據,你才是唯一了。可能是我最為技術型人的一個通病,謝謝大家!

互動環節

問:您剛才提到對采集有屏蔽,那對搜索引擎呢

答:采集和百度爬蟲是一模一樣的原理 還有瀏覽器也是一樣的 所以沒有絕對的屏蔽,相反還會影響客戶體驗,你可以做一些不影響客戶體驗和搜索引擎搜錄 而提高采集難度的嘗試

問:你剛才講的是網頁內容采集,有沒有針對匹配關鍵詞的指定字段的高速采集,比如采集所有帶”IDC“的網頁的郵箱和電話號碼?用過一些,速度很慢,而且數據量明顯太少。

答:我們不做這樣批量的工具,其實比如做論壇發帖機之類的實現起來道理一樣,也很容易,其實實現起來也是可以,只是有更多的一些人工操作 ,我們里面有 正則匹配。。也就是你要的這種單一工具把這種正則都集成在里面了。而我們需要用戶自己去寫

問:采集的復雜度應該就在這吧?頁面規則的不規則性和多變性?

答:在軟件里面設置能夠匹配多種模板的正則表達式,一樣可以采集到多模板的網站,所謂“道高一尺,魔高一丈”。

問:火車頭,能不能說一下怎么把phpcms的文章模塊下的第一級欄目顯示出來啊?

答:用的是 07 還是08版 07版有一個終極欄目的屬性 如果是,就不顯示。

問:火車頭,你覺得哪個CMS比較好用,你給大家推薦一個你最鐘意的CMS系統吧。

答:我現在是對phpcms更熟悉一些。選擇一個適合自己的就夠了。研究透一個。

問:有個采集工具 海納 號稱不要編寫采集規則,不知道有沒有同學研究過,想請教其原理?

答:你說的這個是內容主體識別的范疇了。也做過,但只對一些新聞網站識別得比較好 ,這是一個自動匹配形式的工具,就像百度新聞一樣,能自動匹配到正文數據。對大數據量的提取有好處。但精度相對低點點,因為人工不可控。

問:2008 版本能平滑升級到 2009嗎?我是免費用戶,呵呵。

答:軟件升級:請運行程序目錄下的updateto2009.exe進行升級.支持3.2sp5及2008版到2009版的升級,支持所有用戶

問:請問偽原創的問題怎么處理呢?

答:我們偽原創做得再好,一樣有非常多的會員使用,那樣又不原創了,采集一樣需要技術,只有你通過采集器獲得了沒有多少人有的數據,你才是唯一了。比如我們有同義詞替換功能,這個詞庫就需要最好你自己去擴充一個屬于自己的偽原創。 使用同義詞近義詞替換,排除敏感詞,不同的標簽之間數據融合,指如標題內容之間數據的相互替換給標題。內容分詞。為文章標題等生成拼音地址 給文章加上摘要。采集一些其他編碼的網站,我們可以做到簡繁體轉化,可以采集中文網站翻譯成英文(雖然比較垃圾,但應該可以算是原創)網民,默認的我們能夠自動識別網頁的編碼。但可能也會有出錯的時候,這時候你需要在任務第四頁手工定義一下,比如是gb2312還是utf8等等。

文章地址:http://www.meyanliao.com/article/seo/twzdcjyfcj.html